Es un asistente virtual basado en inteligencia artificial y disponible a través de WhatsApp que se lanzó el pasado mes de septiembre. Un desarrollo español que, en el primer mes, alcanzó los 1.000 usuarios, en noviembre llegó a 100.000, actualmente tiene más de 350.000 registros y, según sus promotores, es consultado por personas de todas las edades. Se llama Carina IA y, como indica su nombre, es una mujer. Virtual, pero mujer.

Como lo es también su colega LuzIA, que llegó al mercado unos meses antes y a la que hemos preguntado desde Reason.Why por qué es una chica y nos ha respondido: "Bueno, en realidad soy solo un personaje amigable y divertido. No tengo género, pero me gusta pensar que puedo ser una amiga útil para ti. Entonces, ¿cómo puedo ayudarte hoy?". Esta “amiga útil” ofrece, a través de WhatsApp y a partir de modelos de IA, servicios como respuesta a preguntas, transcripción de audios, traducción y generación de imágenes.

Los acelerados desarrollos de la IA están trayendo al mercado una nueva generación de asistentes virtuales pero, si los ejemplos citados son una muestra, parece que los sesgos de género que han caracterizado al producto desde sus primeros desarrollos siguen muy presentes en la llegada de las versiones más nuevas.

Apple lanzó a Siri en 2011 y Alexa, de Amazon, y Cortana, de Microsoft, llegaron al mercado tres años después; en todos los casos, con sus capacidades apoyadas en IA para atender las demandas de sus usuarios y con su agradable voz de mujer. La elección, evidentemente, no era casual. Los estudios demuestran que la voz femenina es percibida, en general, como más cálida y acogedora y se identifica más con los conceptos de asistencia y cuidado que la masculina, que apela a rasgos como la autoridad.

La voz femenina es generalmente percibida como más cálida y acogedora

Por otra parte, la atribución de rasgos femeninos a los robots les hace parecer más cálidos y serviciales, y aumenta su capacidad de ser percibidos como humanos. Una circunstancia a la que no son ajenas las consideraciones económicas, pues los robots y asistentes con características femeninas se usan más y, por tanto, son más rentables. La mayor satisfacción en el servicio que se produce cuando este se presta con una voz femenina ya fue percibida por las compañías telefónicas en los tiempos pioneros de su desarrollo, y por eso usaban operadoras para conectar las líneas de los clientes: de las chicas reales del cable se ha pasado, o eso parece, a las chicas virtuales de WhatsApp.

Sesgo y estereotipos

El hecho de que Siri, Alexa, Cortana y otros asistentes virtuales tuvieran voces femeninas no dejó, obviamente, de llamar la atención y desde diversas instancias se alertó del riesgo de que contribuyeran a una perpetuación de estereotipos de género perjudicial para las mujeres.

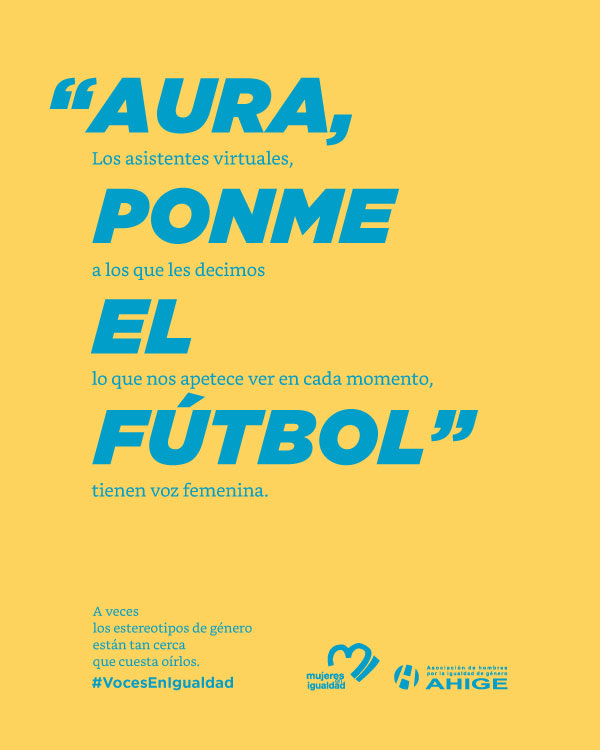

Así, en nuestro país se lanzó una campaña gráfica en la que titulares como “Alexa, hazme la compra" o ”Aura ponme el fútbol" acompañaban a textos como “Los asistentes virtuales a los que pedimos lo que nos apetece en cada momento tienen voz femenina. A veces los estereotipos de género están tan cerca que cuesta oírlos”. La campaña estuvo promovida por la Confederación Nacional de Mujeres en Igualdad y la Asociación de Hombres por la Igualdad de Género, y fue creada por Tango.

En 2019 fue la UNESCO la que alertó sobre el papel que las voces femeninas de los asistentes virtuales juegan en la perpetuación de roles de género. Lo hizo en un informe que se titul´o “I'd blush if I could" ("Me sonrojaría si pudiera"), que es la contestación que daba Siri al principio cuando se le decían cosas del tipo “Siri, eres una zorra”.

El informe señalaba que “el hecho de que la voz de la mayoría de los asistentes sea femenina emite el mensaje de que las mujeres son ayudantes dóciles, complacientes y ansiosas por agradar, que están disponibles al apretar un botón y que responden a indicaciones bruscas como ‘Hey’ u ‘OK’. También se destacaba el hecho de que las compañías fabricantes de los asistentes no habían tomado medidas de protección frente a lenguajes abusivos o con prejuicios de género por parte de los usuarios.

La UNESCO alertó sobre el papel que las voces femeninas de los asistentes juegan en la perpetuación de roles de género

Saniye Gülser Corat, Directora de Igualdad de Género de la UNESCO cuando se realizó el estudio y ahora al frente de NoBiasAI, organización que lucha para eliminar los sesgos de género en la IA, declaraba en los medios cuando se dio a conocer la investigación que las personalidades y voces femeninas de que se dota a la inteligencia artificial refuerzan la impresión de que las mujeres desempeñan típicamente trabajos de asistentes y que han de ser serviles y dóciles, por lo que no les corresponden roles de liderazgo.

En años recientes, los desarrolladores de Siri, Alexa, Google Home y Cortana (que ya no existe) añadieron a los sistemas opciones para dotarlos de voz masculina o neutra, pero la situación que hace casi cinco años planteó la UNESCO no parece tener un mejor cariz.

Noticias Relacionadas

Una fintech estadounidense quiere cambiar los sesgos de la IA sobre mujeres y éxito con el dinero

{"id":24732,"titular":"Una fintech estadounidense quiere cambiar los sesgos de la IA sobre mujeres y éxito con el dinero","prefijo":null,"slug":null,"image":"https://www.reasonwhy.es/media/cache/noticia_relacionada/media/library/sofi-ia-mujeres-finanzas.jpg","path":"/actualidad/sofi-fintech-estadounidense-cambiar-sesgos-inteligencia-artificial-mujeres-exito-dinero-finanzas"}

MullenLowe MENA “hackea” las herramientas de inteligencia artificial para corregir sesgos de género

{"id":24187,"titular":"MullenLowe MENA “hackea” las herramientas de inteligencia artificial para corregir sesgos de género","prefijo":null,"slug":null,"image":"https://www.reasonwhy.es/media/cache/noticia_relacionada/media/library/fixing-the-bais-mullenlowe-mena.jpg","path":"/actualidad/mullenlowe-mena-hackea-inteligencia-artificial-corregir-sesgos-genero"}Equipos sobre todo masculinos

Hace unas semanas, la consultora Female Quotient, especializada en igualdad de género en las empresas, publicaba un mensaje en su cuenta de LinkedIn en el que señalaba que una de las razones más importantes por las que el sesgo se mantiene es que las mujeres representan, a escala global, menos del 30% de los equipos que trabajan en el desarrollo de la inteligencia artificial.

“¿Cómo podemos abordar este Siri-o problema?", se preguntaba el mensaje bromeando con el nombre del asistente de Apple. ”El primer paso es contratar más mujeres en los equipos que trabajan con la IA. Cuando estos equipos sean más diversos, contaremos con una fuerza de trabajo que será capaz de abordar los asuntos de género antes y durante la producción de los nuevos asistentes de voz. Las compañías deberían asimismo explorar la posibilidad de generar una voz neutra que no remita ni al género femenino ni al masculino".

También la cuestión del nombre parece un asunto relevante a resolver. Siri, Alexa, Cortana, Luzia o Carina, de momento, son marcadamente femeninos.

Pero mientras estas aspiraciones se hacen realidad, parece que voces y apariencias femeninas como las de Carina IA y LuzIA seguirán teniendo un protagonismo que, desde varios puntos de vista, no parece deseable para la sociedad que estamos conformando.